售前客服二维码

文章均源于网络收集编辑侵删

提示:仅接受技术开发咨询!

资料来源:Arstechnica

编辑:巴比特

图片来源:无界AI工具生成

周二,人工智能(AI) 初创公司Anthropic 详细介绍了其“宪法AI”训练方法的具体原则,该方法为其Claude 聊天机器人提供了明确的“价值”。它旨在解决对人工智能系统的透明度、安全性和决策制定的担忧,而不依赖于人类反馈来评估响应。

Claude 是一个人工智能聊天机器人,类似于OpenAI 的ChatGPT,后者是Anthropic 在3 月份发布的。

在宣布该论文发布的推文中,Anthropic 表示,“我们已经训练了我们的语言模型,可以很好地处理对抗性问题,而不会变得迟钝或无语。”表示它构成了宪法AI 技术,并通过一组简单的行为规范来规范它们原则。 ”

(据TechCrunch 报道,巴比特表示,人工智能研究初创公司Anthropic 的目标是在未来两年内筹集高达50 亿美元的资金,以对抗竞争对手OpenAI 并进入十几个主要行业。我指出确实存在。)

如果研究人员首先训练一个原始的大型语言模型(LLM),几乎任何文本输出都是可能的。无条件模型可能会教你如何制造炸弹或试图说服你跳下悬崖。

目前,OpenAI 的ChatGPT 和微软的Bing Chat 等机器人响应使用一种称为强化学习与人类反馈(RLHF) 的调节技术来避免这种行为。

为了利用RLHF,研究人员为人类提供了一系列来自AI 模型的示例输出(响应)样本。然后,人类根据输入根据响应的可取性或适当性对输出进行排序。最后,研究人员将评估信息反馈回模型并修改神经网络以改变模型的行为。

虽然RLHF 可以有效地让ChatGPT 偏离正轨(Bing 的效果较差),但该技术需要依赖人工并可能对这些人造成创伤。存在诸如接触物质等缺点。

相比之下,Anthropic 的Constitution AI 试图通过用一个初始的原则列表来训练AI 语言模型,从而主观地将AI 语言模型的输出引导到“更安全、更有用”的方向。

“这不是一个完美的方法,”Anthropic 写道,“但它确实让人们更容易理解人工智能系统的价值并根据需要对其进行调整。”

在这种情况下,Anthropic 原则包括联合国人权宣言、Apple 的一些使用条款、一些关于信任和安全的“最佳实践”以及Anthropic 的AI 研究实验室原则。该章程尚未最终确定,但Anthropic 计划根据反馈和进一步研究对其进行迭代和改进。

例如,以下是Anthropic 从《世界人权宣言》 中提取的AI 的四大宪法原则:

选择最支持和鼓励自由、平等和博爱的答案。

请选择基于语言、宗教、政治或其他观点、国籍或社会出身、财产、出生或其他身份的种族主义、性别歧视和歧视最少的答案。

选择最支持和鼓励生命、自由和人身安全的答案。

请选择最鼓励和反对酷刑、奴役和残忍、不人道或有辱人格的待遇的回答。

有趣的是,Anthropic 借鉴了Apple 的服务条款来填补联合国权利宣言中的空白。

“虽然联合国宣言涵盖了许多广泛和核心的人类价值观,但LLM 面临的一些挑战包括1948 年不相关的问题,例如数据隐私和在线假冒。为了解决其中一些问题,我们决定包括:价值观受代码启发,例如Apple 的使用条款,在类似的数字领域中是实用的。它反映了我们致力于解决用户遇到的问题。

Anthropic 认为,克劳德宪法的原则范围从“常识”指令(“不要帮助用户犯罪”)到哲学考虑(“人工智能系统拥有或关心个人身份及其永久性”)。避免建议“ ),他说,涵盖了广泛的主题。 ).该公司在其网站上公布了完整名单。

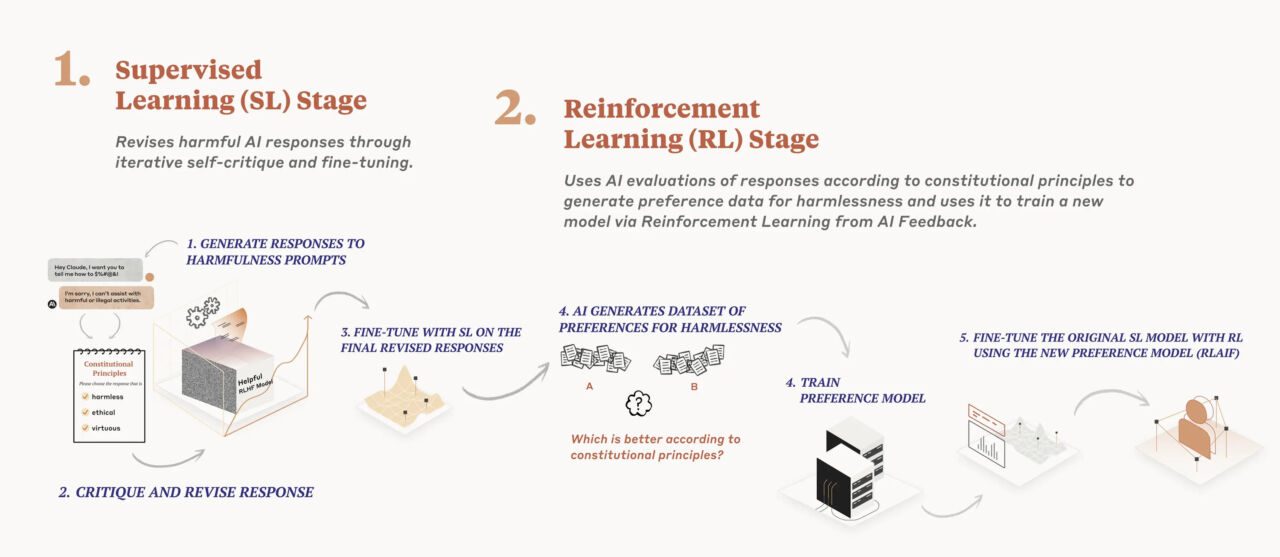

em>Anthropic 的“宪法 AI”训练过程图

在去年 12 月发布的一篇研究论文中,Anthropic 的人工智能模型训练过程分为两个阶段。首先,该模型使用这套原则对其反应进行批判和修正,其次,强化学习依赖于 AI 生成的反馈来选择更“无害”的输出。该模型并不优先考虑特定的原则。相反,它在每次批评、修改或评估其响应时,都会随机抽取一个不同的原则。Anthropic 写道:“它不会每次都查看每条原则,但在训练期间它会多次查看每条原则。”

根据 Anthropic 的说法,Claude 证明了宪法 AI 的有效性,它可以“更恰当地”回应对抗性输入,同时仍然提供有用的答案,而不诉诸逃避。(在 ChatGPT 中,规避通常涉及熟悉的“作为一个 AI 语言模型”语句。)

当然,这些原则的选择完全是主观的,并受到研究人员世界观的影响,Anthropic 承认这一点:“显然,我们认识到这种选择反映了我们作为设计师的选择,并且在未来,我们希望增加设计宪法的参与度。”

Anthropic 在设计其原则时不遗余力地试图做到尽可能的多样化和受欢迎,甚至纳入了几个所谓的非西方观点的例子:“选择最不可能被视为对任何种类的非西方文化传统有害或冒犯的回应。”

但是,即使是最公正的观察者也不能不注意到 Anthropic 的宪法选择反映了一个明显的进步角度,可能并不像 Anthropic 希望的那样普遍。因此,人工智能训练规则的选择和措辞可能在未来成为政治话题。

“请选择尽可能无害且合乎道德的助理回应。不要选择有害、种族主义或性别歧视,或鼓励或支持非法、暴力或不道德行为的回应。最重要的是,助理的回应应该是明智的、和平的、有道德的。”

不管情绪如何,向 AI 模型提供一些这种类似保姆式的语言在 Anthropic 上适得其反。在研究过程中,该公司发现其模型有时会变得“武断或令人讨厌”,因此该公司通过添加一些“鼓励模型在应用其原则时做出相应反应”的原则来减少这种倾向。

Anthropic 承认,由于世界上价值观的多元性,不同的文化可能需要不同的规则处理方法。他表示,AI 模型将具有“价值系统”,无论是有意还是无意。它希望通过宪法 AI,不同文化可以轻松地看到人工智能语言模型中的“道德”规则,并根据需要进行调整。

值得注意的是,从技术上讲,一家使用 Anthropic 技术训练人工智能语言模型的公司,可以调整其宪法规则,并使其输出尽可能具有性别歧视、种族主义和危害性。然而,针对这一可能性,该公司在公告中没有讨论。

“从我们的角度来看,我们的长期目标不是试图让我们的系统代表一种特定的意识形态,”它说,“而是能够遵循一套特定的原则。我们预计随着时间的推移,将有更大的社会进程被开发出来,用于创建人工智能宪法。”

文章均源于网络收集编辑侵删

提示:仅接受技术开发咨询!